在2023年全球超算大会(SC2023)上,NVIDIA 发布了 H100 芯片的继任者,目前世界最强的 AI 芯片——H200。

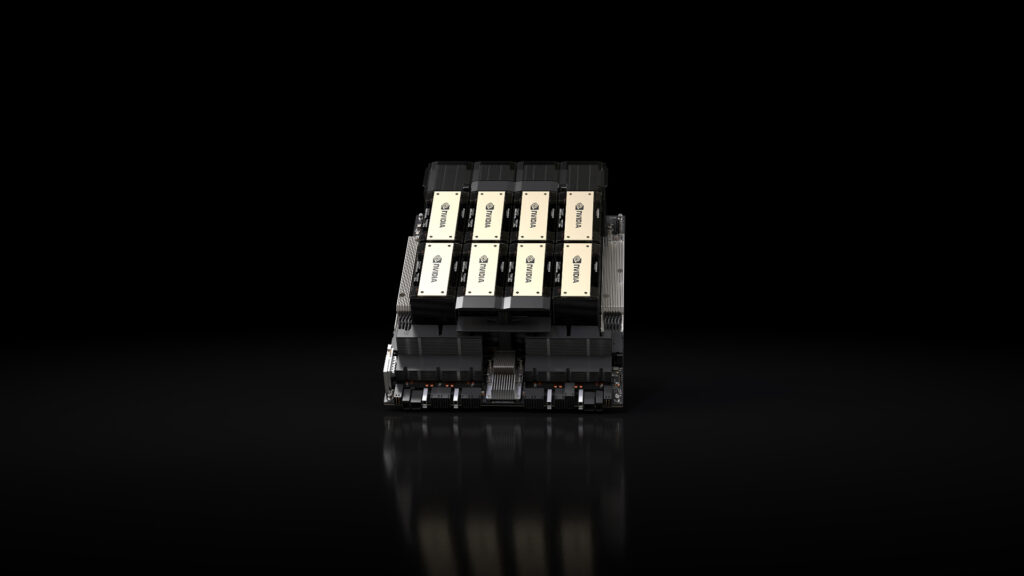

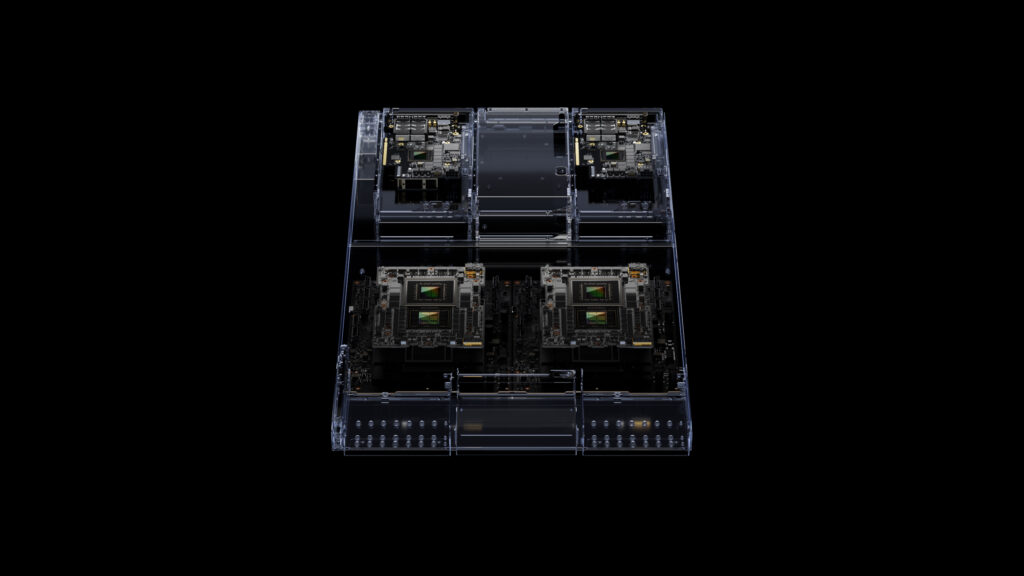

NVIDIA HGX H200 芯片为全球领先的 AI 运算平台带来强大动力。该平台基于 NVIDIA Hopper 架构,配备 NVIDIA H200 Tensor Core GPU,并具有先进的记忆体,可为生成式 AI 和高效能运算的工作负载处理大量资料。

NVIDIA H200 是首款提供 HBM3e 的GPU,HBM3e 是速度更快、容量更大的记忆体,可加速生成式 AI 和大型语言模型,同时推进高效能运算工作负载的科学运算。借助 HBM3e,NVIDIA H200 以每秒 4.8 TB 的速度提供 141GB 记忆体,与其前代产品 NVIDIA A100 相比,容量几乎翻倍,频宽增加2.4 倍。

NVIDIA Hopper 架构与其前代架构相比,实现了前所未有的效能跃进,并透过 H100 的持续软体增强,包括像是最近释出 NVIDIA TensorRT™-LLM 的开源库,不断提高效能水准。

NVIDIA H200 将带来更进一步的效能跃进,包括相对于H100,在 Llama 2 这样一个拥有 700 亿参数大型语言模型上的推论速度将近翻倍提升。未来的软体更新预计将为H200 带来额外效能的领先优势,并持续最佳化 H200。相较于于其前任产品H100,H200的性能直接提升了60%到90%。

NVIDIA H200 将提供包含具有四路和八路配置的NVIDIA HGX H200 伺服器主机板,其软硬体皆与HGX 100系统相容。此外,NVIDIA H200 亦可与今年8 月推出、采用 HBM3e 的NVIDIA GH200 Grace Hopper 超级晶片搭配使用。

最后,NVIDIA 表示 H200 预计将于 2024年第二季度出货,售价还暂未公布。

猜你喜欢

——NVIDIA Broadcast 1.4加入眼神交流功能,利用AI“模拟”用户眼神直视画面

——Samsung 推出 Galaxy AI,可在打电话时进行实时翻译